Вчимося розпізнавати діпфейк: «мертві» очі та прозора рука

В інформації, яка лавиною подається звідусіль, і так важко розібратися, де правда, а де брехня – а зараз сюди ще додалися вигадані відеовиступи відомих людей.

Зверніть увагу! Усі наведені нижче відео – фальшивка. Ми їх даємо лише для прикладу.

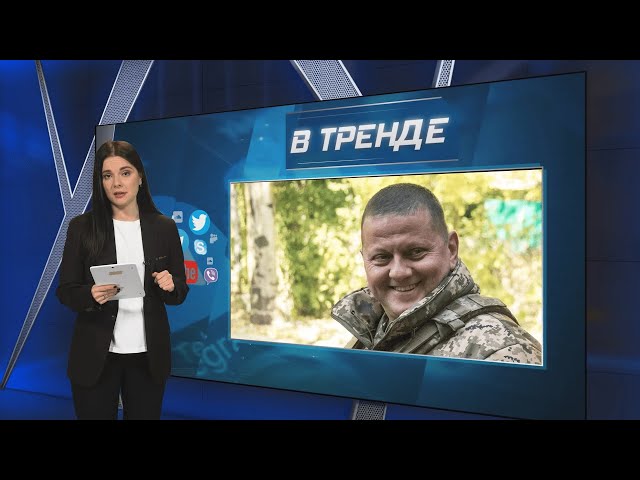

Останніми днями українці зіткнулися з кількома діпфейками, що імітують виступи головних осіб країни. Наприклад, зімітували звернення Головнокомандувача ЗСУ Валерія Залужного до народу з оголошенням державного перевороту. Або діпфейк-відео спікера Міністерства оборони України Юрія Ігната, де проскакує недруковане слівце після розповіді про збиті російські ракети. А скільки було брехливих відео з «президентом України» – то він оголошує про відставку, то страшно лається…

Усе це нас дезорієнтує. Ми вже насилу розуміємо, де правда, а де вигадка – правильні слова говорить на відео наш офіційний представник, а що з матюком – так життя таке… І начебто зрозуміло, кому вигідно і хто це робить - ворог не соромиться застосовувати будь-які брудні технології. Ось тільки поки не зрозуміло, як відрізняти реальну подію від вкидання. Особливо, якщо тобі показують відео, на якому відома людина з впізнаваним голосом.

Діпфейк – «глибоке підроблення/обман» - технологія підміни обличчя однієї людини іншою за допомогою алгоритмів машинного навчання. Простіше кажучи, штучний інтелект все більше захоплює нас, змушуючи вірити в те, чого не існує, видаючи повну дезінформацію.

Звичайно, в ідеалі ця система могла б працювати тільки в плюс: уявіть Ван Гога, який «ожив» і розповідає про свої картини, або красуню «Одрі Хепберн», що грає головну роль у сучасному фільмі (до речі, саме через побоювання, що їх замінять діпфейками, і страйкували голлівудські актори цього року (нижче ролик, як замінили обличчя Хав'єра Бардема у фільмі «Старим тут не місце» - на обличчя Роуена Аткінсона).

А пам'ятаєте березневий скандал на нашому ТБ, коли один із телеканалів вирішив замінити у серіалі російського актора Прохора Дубравіна українським Дмитром Саранським? Причому у вже знятому серіалі просто наклавши обличчя одного артиста на іншого? Серіал після скандалу вирішили відкласти, але прецедент залишився!

І, звичайно, діпфейк - це не тільки сумнівна розвага або спосіб заробітку. Це ще й складова інформаційних атак.

До повної відповідності

Діпфейки не беруться з нізвідки. Спеціальні програми (вони вже є у широкому доступі) аналізують зображення людей, злиті до інтернету. Всі ваші фотографії з відпочинку, у кафе, на роботі, з дітьми та собаками – все це вивчається штучними мізками та аналізується.

Потім все дуже просто. Працюють два алгоритми: один створює відео на підставі цих даних, другий критикує, вказуючи на недоліки в спробах відрізнити оригінал від підробки. Потім знову створюється відео… І так доти, поки обидва алгоритми не вирішать, що ось тепер відео досить реалістичне.

Якщо комусь цікаво, то цю технологію розробив 2014 року студент Стенфордського університету Ян Гудфеллоу. У 2017-му на інтернет-форумі Reddit хтось з ніком deepfake замінив обличчя порноактрис обличчями знаменитостей. І почалось! До речі, зараз 96% діпфейків – саме ті, лише для дорослих.

Програмо, допоможи!

Тяжко, особливо якщо ви не маєте відношення до IT, програмування, інженерії. Програми, що розпізнають підроблені обличчя та голоси, вже є, але чи буде пенсіонер запускати, скажімо, Microsoft Video Authenticator, щоб зрозуміти, хто просить у нього грошей через Вайбер – дочка чи шахрайка, яка «наділа» її обличчя. Самого Марка Цукерберга, засновника Facebook, вже «сдіпфейчили», і зараз він разом із університетом Мічігану розробляє детектор фальшивих зображень.

Якщо ж ви маєте намір розібратися і допомогти розібратися ближньому, скористайтеся цими програмами, за допомогою яких можна виявити діпфейки:

- Forensically – простий та зрозумілий набір безкоштовних інструментів для аналізу зображень.

- Image Edited - безкоштовний сервіс, який шукає зміни у фотографіях, аналізує зображення на рівні пікселів та їх кольорів.

- Ghiro - автоматично аналізує величезну кількість зображень з метою проведення криміналістичного аналізу.

- Truepic - перевіряє фото та відео щодо внесених змін.

- KaiCatch - розпізнає аномалії та спотворення у фото і відео за допомогою ІІ.

- Microsoft Video Authenticator – оцінює фото та відео і визначає ймовірність монтажу.

- Deepware – безкоштовний інструмент для аналізу відео.

Гладенький лоб та різні очі

Для нефахівців існують інші ознаки фальшивих фото та відео, але доведеться бути дуже уважним, розпізнаючи підробку.

1. Проста логіка. Якщо персонаж відео говорить немислимі для себе, свого статусу чи оточення речі, це підробка. Не може головком ЗСУ чи президент у своєму відеозверненні використовувати нецензурні вислови. Не можуть Брюс Вілліс або Роуен Аткінсон – популярні персонажі дипфейків – швидко говорити будь-якою іншою мовою, крім своєї рідної. Хоча з Брюсом Віллісом складніше - через хворобу актор вже не може зніматися в кіно, але продав права на використання свого цифрового образу компанії Deepcake. І ось його обличчя – без зйомок наживо – вже миготить у рекламних роликах, у російських, між іншим). Брюс Вілліс – поки що перший такий актор, але, на жаль, не останній.

Але повернемось до логіки. Наприклад, глава банку не «даруватиме гроші за посиланням». Якщо публічна особа захоче зробити важливу заяву, вона скористається офіційними каналами зв'язку, а не маловідомим акаунтом. І так далі. До речі, офіційні канали, як би ми їх не критикували, залишаються таким собі острівцем реальності.

2. Зазвичай за допомогою діпфейків змінюють саме обличчя. Якщо йдеться про політиків і потрібно швидко склепати фальшивку на злобу дня, то виконавці досить кострубато монтують обличчя до тіла. Та й не тільки про політиків – щоб все було природно, потрібно чимало попрацювати, а на це не всі готові. Отже, варто порівняти статуру персонажа з його зображенням в інших джерелах.

3. Неприродно гладка шкіра. Така насправді може бути у добре доглянутих жінок чи любительок «фільтрів» в Інстаграмі. Всі інші будуть мати зморшки, складки, вм'ятинки, нерівномірний колір обличчя через гру світла. Ми всі живі люди. Але коли з екрану мовить літній персонаж, і на обличчі його жодного проблиску хоча б мікрогримаси плюс абсолютно гладка молода шкіра – це з високою ймовірністю буде фейк.

4. В області очей та брів можуть бути неприродні тіні, які не збігаються з жестами та мімікою персонажа. До речі, очі у нього будуть «мертві» - дивитися в одну точку або рухатися суто механічно, неприродно, в них не буде відблисків, іскорок, перепадів світла, реакції на слова чи ситуацію. Усміхнений персонаж, в очах якого застиг суворий вираз або подив, це стовідсотковий фейк. Іноді очі не збігаються за кольором чи розміром. А ще діпфейки дуже рідко або дуже часто моргають.

5. На окулярах, якщо вони є, відблиски якраз і будуть, тільки незрозуміло звідки. Окуляри взагалі можуть бути згенеровані, як маска в FaceApp, наприклад. Одна сторона носа може бути темнішою або світлішою за іншу, ніздрі можуть відрізнятися за формою. Це результат невмілого накладання маски діпфейка.

6. З волоссям теж біда - поки штучному інтелекту не виходить зробити фальшиве волосся ідентичне справжньому. Придивіться до межі волосся та шкіри, вона «гулятиме» або розташовуватиметься не там, де зазвичай. У діпфейк-чоловіків можуть виникнути бакенбарди.

7. Зуби у діпфейк-персонажа не промальовані і виглядають як єдина біла пляма, яка ще й не завжди рухається у такт губам. А губи не збігаються з тим, що людина каже.

8. І знову – очі. Експерти порівнюють світло, відбите у рогівках. На фотографії реальної людини, зробленої камерою, відображення у двох очах буде однаковим, тому що вони бачать одне й те саме. У діпфейка в очах буде незрозуміло що й різне.

9. Якщо попросити співрозмовника на відео повернутись у профіль, то обличчя діпфейка відразу ж «попливе». Поки що жодна маска не в змозі створити правдоподібний профіль людини, яка повернула обличчя на 90 градусів. Маска «спливає», починають виявлятися риси реальної людини. Справа в тому, що ІІ аналізує фотографії в соцмережах, а там люди зображені переважно анфас. Коректно «повернути» голову програма не може – мало даних…

10. Також якщо діпфейк помахає рукою перед обличчям, можна без особливої напруги побачити проблеми накладання реального об'єкта на згенерований. Рука, що проходить через мікрофон на одній із торішніх нібито офлайн-зустрічі лідера країни-агресора, - це воно й було.

До речі, зі свіженького. 14 грудня на прямій лінії до Путіна звернувся його двійник, створений за технологією діпфейк. Запитував також про двійників.

11. Щоб на вудку попалися неуважні, шахраї часто записують відео низької якості, щоб приховати перешкоди, описані вище. Ми живемо в XXI столітті, і в найдешевшому смартфоні вже досить висока якість відео та фото. Тож і цей діпфейк може бути швидко розвінчаний.

12. Антураж діпфейка. Повідомлення, в якому використовується згенероване для обману зображення, зазвичай має помітний заголовок (клікбейт), який може навіть шокувати. Найчастіше на теми:

- порнографія,

- як швидко розбагатіти/схуднути,

- політичні/соціальні резонансні теми (мобілізація, підвищення тарифів, закриття кордонів, вибори тощо),

- дискредитація будь-кого.

Ще раз: вся реальна інформація знаходиться на офіційних сайтах або йде від уповноважених осіб. У повідомленнях з діпфейком можуть бути граматичні та орфографічні помилки, багато знаків оклику, капслок, фрази «Не хотілося в це вірити, але САМ сказав» або «Термінове повідомлення до всіх!» Всі реальні термінові повідомлення йдуть по всіх каналах, у тому числі по телебаченню та радіо. Можна звірити і зрозуміти, що у повідомленні – діпфейк.

13. Не варто забувати про існування гумористичних сайтів, які великими літерами на першій сторінці пишуть, що їхні новини є сатиричною вигадкою. Там діпфейки можуть бути частково виправдані. Шкода, що іноді ці новини передруковують у себе серйозні ЗМІ, не переймаючись перевіркою фактів.